텐센트가 공개한 오픈소스 비디오 생성 모델, Hunyuan Video 1.5는 어떻게 소비자용 GPU에서 SOTA급 성능을 달성했을까요? Unified DiT 구조부터 Glyph-ByT5를 활용한 텍스트 렌더링, 그리고 혁신적인 희소 어텐션(Sparse Attention) 기법까지 기술적 정수를 낱낱이 파헤칩니다.

최근 생성형 AI 시장, 특히 비디오 생성 분야는 그야말로 춘추전국시대입니다. OpenAI의 Sora, Google의 Veo, Kuaishou의 Kling 등 내로라하는 모델들이 등장하며 '텍스트 투 비디오(Text-to-Video)'의 한계를 매일 갱신하고 있습니다. 하지만 이들 대다수는 독점적인(Proprietary) 모델로, 내부 아키텍처가 베일에 싸여 있거나 API 형태로만 접근이 가능했습니다.

오픈소스 진영에서도 Wan 2.2와 같은 시도들이 있었지만, 한계는 명확했습니다. 고품질 비디오를 생성하기 위해 14B 파라미터 모델 두 개를 혼합하는 MoE(Mixture of Experts) 방식을 채택하다 보니 총 파라미터가 27B에 달해 막대한 컴퓨팅 자원이 필요했거나, 반대로 경량화된 5B 모델은 3D VAE의 압축 손실로 인해 전문가급 품질을 내지 못했습니다. 즉, '접근성'과 '품질' 사이의 거대한 간극이 존재했던 것입니다.

이러한 상황에서 등장한 Hunyuan Video 1.5는 게임 체인저라 불릴 만합니다. 단 8.3B(83억) 파라미터만으로 구성된 이 모델은 소비자용 GPU(예: RTX 4090) 한 장에서도 추론이 가능할 만큼 효율적이면서도, 비주얼 품질과 모션의 일관성 측면에서 최상위권 성능을 보여줍니다.

이번 포스팅에서는 Hunyuan Video 1.5 기술 보고서를 바탕으로, 이 모델이 어떻게 경량화와 고성능이라는 두 마리 토끼를 잡았는지 엔지니어링 관점에서 심층 분석해 보겠습니다.

1. Unified DiT: 통합된 확산 트랜스포머의 설계 미학

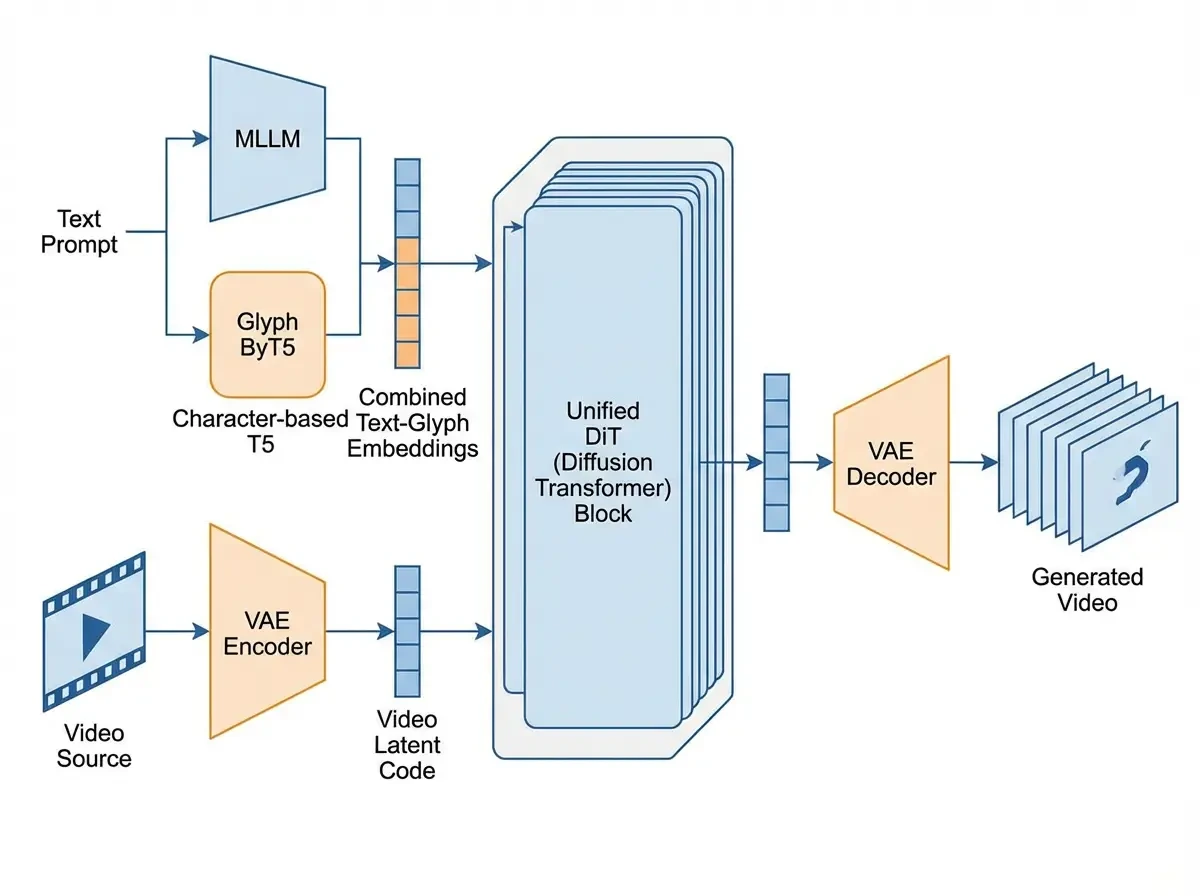

Hunyuan Video 1.5의 심장은 통합 확산 트랜스포머(Unified Diffusion Transformer, DiT)입니다. 기존의 U-Net 기반 확산 모델들이 고해상도 영상 생성에서 한계를 보인 반면, DiT는 트랜스포머의 스케일링 법칙(Scaling Law)을 비디오 생성에 적용하여 뛰어난 확장성을 보여줍니다.

🔧 다중 작업 학습 (Multi-Task Training)

이 모델의 가장 큰 특징은 텍스트-투-이미지(T2I), 텍스트-투-비디오(T2V), 이미지-투-비디오(I2V)를 별도의 모델이 아닌 하나의 통합된 아키텍처에서 처리한다는 점입니다.

특히 I2V 작업 시, 참조 이미지(Reference Image)를 모델에 주입하는 방식이 매우 정교합니다.

- 채널 결합 (Channel Concatenation): 참조 이미지를 VAE로 인코딩한 잠재 벡터(Latent)를 노이즈 잠재 벡터와 채널 차원에서 결합합니다. 이는 이미지의 세부적인 디테일을 복원하는 데 기여합니다.

- 어텐션 주입 (Attention Injection): SigLip과 같은 비전 인코더로 추출한 의미론적 특징(Semantic Feature)을 어텐션 레이어에 주입하여, 이미지가 가진 의미와 스타일을 유지하도록 합니다.

또한, '학습 가능한 타입 임베딩(Learnable Type Embedding)'을 도입하여 모델이 현재 수행 중인 작업이 텍스트 기반인지 이미지 기반인지 명확히 구분하게 했습니다.

📦 3D Causal VAE: 압축의 기술

비디오 데이터는 그 크기가 방대하기 때문에, 이를 그대로 모델에 넣는 것은 불가능에 가깝습니다. Hunyuan Video 1.5는 이를 해결하기 위해 고도로 최적화된 3D Causal VAE(Variational Autoencoder)를 사용합니다.

이 VAE는 공간(Spatial) 차원에서 16배, 시간(Temporal) 차원에서 4배의 압축률을 달성합니다. 여기서 'Causal(인과적)'이라는 단어가 중요한데, 이는 시간 축 압축 시 미래의 프레임을 참조하지 않고 과거의 프레임만으로 압축을 수행한다는 뜻입니다. 덕분에 비디오 생성 시 시간적 순서가 꼬이지 않고, 실시간 스트리밍 생성 등에도 유리한 구조를 갖추게 되었습니다. Latent Channel Dimension은 32로 설정되어 정보의 손실을 최소화하면서도 효율적인 연산을 가능케 합니다.

2. SSTA: 연산 효율성의 극대화

트랜스포머 모델의 고질적인 문제는 입력 시퀀스의 길이가 길어질수록 연산량이 제곱($O(N^2)$)으로 증가한다는 것입니다. 비디오 생성에서는 프레임 수가 늘어날수록 토큰(Token)의 양이 폭발적으로 증가하기 때문에, 일반적인 Full Attention(전체 어텐션)을 사용하면 메모리가 터져버리거나 속도가 극도로 느려집니다.

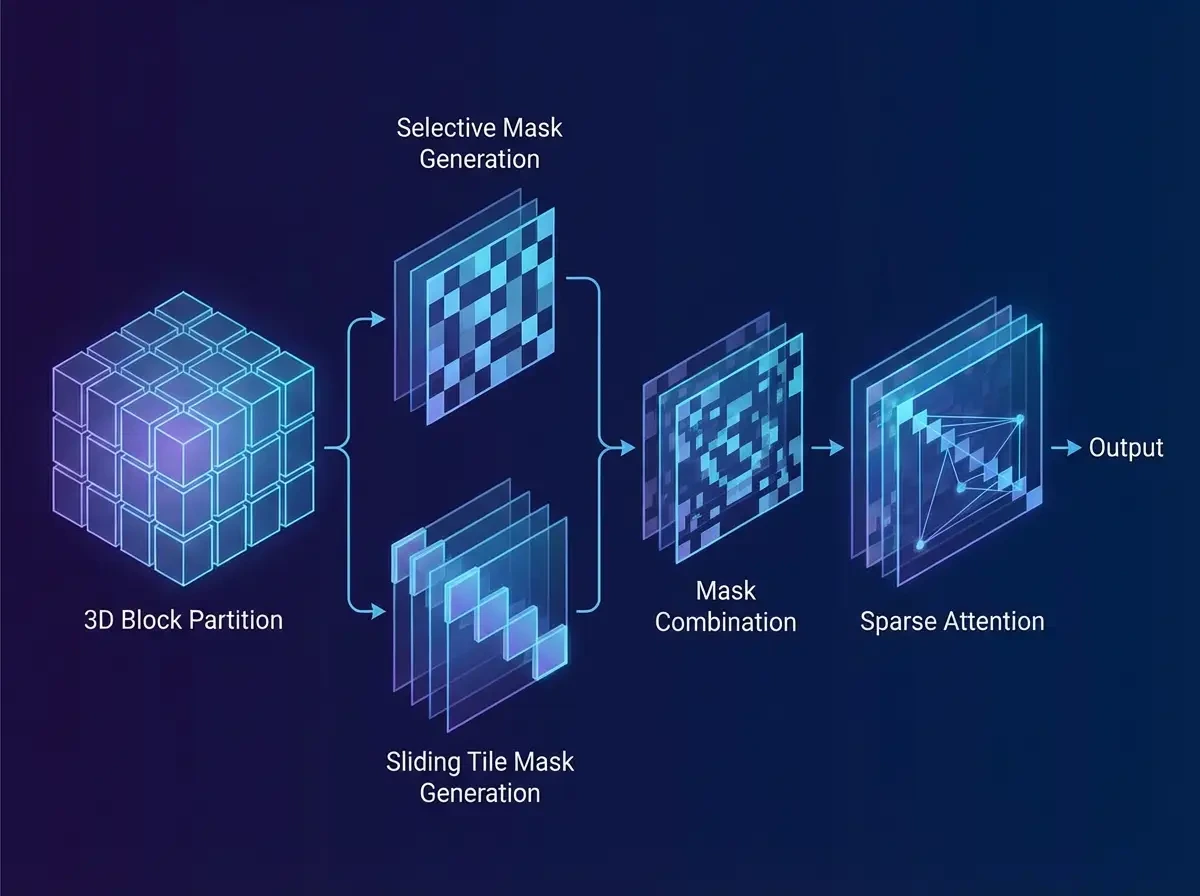

Hunyuan Video 1.5는 이를 해결하기 위해 SSTA (Selective and Sliding Tile Attention)라는 독자적인 희소 어텐션 메커니즘을 제안했습니다.

⚡ SSTA의 작동 원리

SSTA는 비디오 데이터가 가진 '시공간적 중복성(Spatiotemporal Redundancy)'에 주목했습니다. 영상의 모든 픽셀이 서로 연관되어 있지는 않다는 점을 이용해, 불필요한 연산을 과감히 쳐내는 방식입니다.

- 3D 블록 분할 (3D Block Partition): Query와 Key 텐서를 작은 3D 블록 단위로 쪼갭니다.

- 선택적 마스크 (Selective Mask): 블록 간의 유사도를 계산하여, 연관성이 높은 중요한 블록(Top-k)만 선택합니다. 이는 전역적인(Global) 문맥을 놓치지 않게 해줍니다.

- 슬라이딩 타일 마스크 (Sliding Tile Mask): 현재 블록 주변의 국소적인(Local) 윈도우 내 블록들은 무조건 참조하게 합니다. 이는 영상의 연속성과 디테일을 보장합니다.

이 두 가지 마스크를 결합하여 실제로 연산이 필요한 부분만 계산함으로써, 긴 시퀀스에서도 선형에 가까운 효율성을 확보했습니다.

🚀 FlashAttention-3와의 비교

결과는 놀랍습니다. 10초 분량의 720p 비디오를 생성할 때, 최신 최적화 기술인 FlashAttention-3를 사용했을 때보다 1.87배 더 빠른 종단 간(End-to-End) 추론 속도를 기록했습니다. 특히 이 방식은 별도의 학습 파라미터가 필요 없는(Parameter-free) 구조라, 기존 모델에 바로 적용하거나 학습 중간에 도입해도 성능 저하 없이 속도만 높일 수 있다는 강력한 장점이 있습니다.

3. 멀티모달 텍스트 이해: "글자를 그리는 AI"

기존 비디오 생성 AI들이 가장 어려워하는 것 중 하나가 바로 영상 내에 정확한 텍스트(간판, 자막 등)를 생성하는 것입니다. 뭉개지거나 외계어처럼 나오는 경우가 다반사였죠. Hunyuan Video 1.5는 이중 텍스트 인코더(Dual-Channel Text Encoder) 전략으로 이 문제를 정면 돌파했습니다.

📚 MLLM과 Glyph-ByT5의 협주

이 모델은 텍스트를 이해하기 위해 서로 다른 장기를 가진 두 개의 뇌를 사용합니다.

- Qwen2.5-VL (MLLM): 대규모 멀티모달 모델을 사용하여 사용자의 프롬프트가 묘사하는 장면, 분위기, 복잡한 인과관계 등 '의미론적(Semantic)' 내용을 깊이 있게 파악합니다.

- Glyph-ByT5: 이것이 핵심입니다. 일반적인 텍스트 인코더가 단어 단위로 처리하는 것과 달리, ByT5는 바이트 단위, 즉 글자의 형태(Glyph) 자체를 인식하도록 특화되어 있습니다.

Glyph-ByT5 덕분에 Hunyuan Video 1.5는 영어뿐만 아니라 한자(Chinese characters)와 같은 복잡한 문자도 획 하나하나 정확하게 렌더링할 수 있게 되었습니다. 이는 광고 영상이나 타이포그래피가 중요한 콘텐츠 제작에 있어 결정적인 차별화 포인트입니다.

4. VSR: 1080p 화질의 완성

Hunyuan Video 1.5는 고해상도 영상을 한 번에 생성하지 않습니다. 효율성을 위해 2단계(Cascaded) 파이프라인을 채택했습니다.

- 1단계 (Base Generation): 먼저 통합 DiT 모델이 480p에서 720p 해상도의 기본 영상을 생성합니다. 이때는 영상의 구조와 움직임에 집중합니다.

- 2단계 (Video Super-Resolution, VSR): 생성된 저해상도 영상을 별도로 훈련된 VSR 네트워크에 통과시켜 1080p로 업스케일링합니다.

이 VSR 네트워크 역시 8.3B 파라미터의 DiT 구조를 따르지만, 픽셀 공간이 아닌 잠재 공간(Latent Space)에서 업스케일링을 수행한다는 점이 기술적 특징입니다. 저해상도 잠재 변수(Latent)와 노이즈를 채널 방향으로 결합(Concatenate)하여 입력으로 사용하며, 이를 통해 단순히 해상도만 늘리는 것이 아니라 뭉개진 텍스처를 복원하고 영상의 선명도를 획기적으로 개선합니다. 또한 왜곡 보정(Distortion Correction) 기능까지 수행하여 최종 결과물의 완성도를 높입니다.

5. 데이터 엔지니어링: 양보다 질

"Garbage in, Garbage out"은 AI 학습의 불변의 진리입니다. Hunyuan 팀은 무려 1,000만 시간 분량의 원본 비디오 데이터를 수집했지만, 이를 그대로 쓰지 않고 3단계의 가혹한 필터링을 거쳤습니다.

🧹 3단계 정제 프로세스

- 기본 필터링: 영상에 검은 테두리가 있거나, 너무 정적(움직임이 없는)이거나, 화면이 깨진 영상들을 1차적으로 걸러냅니다.

- 품질(Visual Quality) 필터링: 자체 개발한 평가 모델을 통해 선명도, 노이즈, 다이내믹 레인지 등을 점수화하여 기준 미달 영상을 폐기합니다.

- 미적(Aesthetic) 필터링: 구도, 조명, 색감 등 인간이 보기에 '아름다운' 영상만을 선별합니다.

이 과정을 통해 최종적으로 살아남은 데이터는 약 8억 개의 고품질 클립이었습니다. 또한, 학습 데이터의 캡션(설명)을 생성할 때도 환각(Hallucination)을 줄이고 설명의 풍부함은 유지하기 위해 RL(강화학습) 기반의 OPA-DPO 기법을 적용했습니다. 이는 AI가 영상을 잘못 해석해서 엉뚱한 설명을 다는 것을 방지하고, 영상 내의 카메라 무빙이나 조명 정보까지 상세하게 텍스트화하여 학습시키는 데 기여했습니다.

6. 성능 평가 및 결론

그렇다면 실제 성능은 어떨까요? 100명 이상의 전문 평가단이 진행한 GSB(Good/Same/Bad) 블라인드 테스트 결과는 다음과 같습니다.

| 비교 모델 | T2V 승률 (Hunyuan 우세) | I2V 승률 (Hunyuan 우세) |

|---|---|---|

| Wan 2.2 | +17.12% | +12.65% |

| Kling 2.1 | +12.60% | +9.72% |

| Veo 3 | -10.32% | -3.61% |

Hunyuan Video 1.5는 오픈소스 경쟁자인 Wan 2.2를 압도하는 것은 물론, 상용 서비스인 Kling 2.1보다도 높은 평가를 받았습니다. 비록 구글의 Veo 3에게는 다소 밀리는 모습을 보였으나, 오픈소스 모델이 폐쇄형 SOTA 모델과 경쟁 가능한 수준까지 올라왔다는 점은 시사하는 바가 큽니다.

마치며: 오픈소스 비디오 AI의 새로운 지평

Hunyuan Video 1.5의 공개는 연구자와 개발자들에게 큰 선물입니다. 전체 파이프라인이 소비자용 GPU(RTX 4090 등, VRAM 13.6GB 이상)에서 구동 가능하다는 점은 AI 비디오 창작과 연구의 진입 장벽을 획기적으로 낮췄습니다.

단순히 모델 가중치만 공개한 것이 아니라, SSTA와 같은 효율화 기술, VSR 업스케일링 네트워크, 정교한 데이터 처리 방법론까지 공유함으로써 오픈소스 생태계 전체의 수준을 한 단계 끌어올렸다고 평가할 수 있습니다. 앞으로 이 모델을 기반으로 어떤 창의적인 파생 모델과 애플리케이션들이 쏟아져 나올지 기대됩니다.

※ 본 포스팅은 Hunyuan Video 1.5 Technical Report를 기반으로 작성되었습니다.

'🚀 AI 연구소 > AI 기술 & 딥러닝' 카테고리의 다른 글

| 대학원생이라면 필독! 논문 작성이 쉬워지는 AI 도구 BEST 5 (1) | 2025.03.07 |

|---|---|

| 딥러닝 모델 성능을 높이는 핵심 튜닝 방법 총정리 (실무자를 위한 고급 가이드) (0) | 2025.03.03 |

| MU-Net: Deep Learning-based Thermal IR Image Estimation from RGB Image 번역 (0) | 2021.05.12 |

| Deep Convolutional Neural Network-based Fusion of RGB and IR Images in Marine Environment 번역 (0) | 2021.05.11 |

| 논문 번역 AUTOMATIC PARKING OF SELF-DRIVING CAR BASED ON LIDAR (0) | 2021.05.06 |

댓글